在DeepSeek等大模型的推动下,中国医疗行业的智能化进程在加快,有超过100家医院完成DeepSeek的本地部署,还有民众靠DeepSeek隔空把脉抓中药,但AI医师真的靠谱吗?

医院会诊室内,13名北京儿童医院知名专家围坐在会议室,神情专注,与这些顶级专家一同会诊的,还有中国首位AI儿科医师。

屏幕上即时展示着一名疑难病例患儿脑部的磁共振成像影像,随着工作人员将患儿病历及相关影像数据等输入电脑,最终,AI给出的建议与现场专家们的会诊结果高度吻合。这次会诊由北京儿童医院院长、耳鼻咽喉头颈外科专家倪鑫主持。他表示,「大家当时看到结果都很惊讶」。如今,每周四,倪鑫都会主持有AI儿科医师参与的专家会诊,对五至十名患儿的病情全位讨论。

★医疗AI 加速涌入医院

DeepSeek的影响力也已蔓延到了门诊患者中,AI加速涌入医院。过去,人们看病前可能会用百度搜索相关资讯,而现在DeepSeek提供了更系统化的建议。复旦大学附属华山医院(下称「华山医院」)神经内科主任医师郁金泰表示,DeepSeek可看作是患者自查工具的「升级版」。

如今,医疗AI大模型正如雨后春笋般涌现。几乎每天都有医院宣布在DeepSeek基础上部署AI大模型,或公布与企业合作研发的垂直AI大模型。北京儿童医院的AI儿科医师便是后者,该大模型由北京儿童医院联合北京百川智能科技有限公司(下称「百川智能」)等共同研发。

王小川第一天创立百川时,就想「造医师」,即打造具备专业诊疗能力的AI医师,在儿科医师严重缺乏的情形下,北京儿童医院和百川智能在AI儿科医师项目一拍即合。

「AI大模型就像在『造人』,它能够模拟人类的思维方式。」百川智能医疗副总裁李施政表示,最开始百川智能提及的是要「造医师助手」。结果,倪鑫主动提出「要造100万个儿科医师」。

目前,除了北京儿童医院、华山医院,全国多家知名三甲医院都在积极部署AI大模型。AI已覆盖科研、临床等多个应用场景,除了辅助医师提供诊疗建议外,还能在医师接诊前自动收集和整理患者病历。

★AI幻觉 误判干扰信号

然而,AI的输出结果主要基于统计数据。更关键的问题是:AI幻觉似乎难以避免。所谓幻觉,是指大模型在回答问题时编造资讯。

华中科技大学同济医学院附属同济医院感染科副主任医师郭威表示,临床使用中,AI偶尔会出现一些令人啼笑皆非的错误。他举例说,影像学的变化非常复杂,有时所看到的可能是无诊断价值的「干扰信号」,而AI有时会将其判断为病变。

西部某省会城市,一家三甲医院外科主任医师赵霖(化名)也经历了AI幻觉。他在为学生准备外科课程时,让DeepSeek协助制作PPT,结果发现它开始编造内容,包括杜撰医学名词出处、虚构参考文献等。他由此产生了疑问:如果AI用于医学辅助决策,如何确保它推荐的方案是基于真实指南,而不是凭空捏造的?

幻觉通常会被AI自信地呈现,使得它们有时难以被察觉。而幻觉的产生,与模型的训练内容密切相关。郁金泰表示,AI的可靠性取决于输入数据的准确性和专业性。如果输入的资讯有误,输出的结果同样会存在偏差。

李施政指出,虽然AI模型出错较为常见,但在医疗领域,错误必须严格控制,尤其在用药建议环节。为确保错误率远低于人类医师,AI医师的工作必须严格遵循医学原则,即所有决策都必须基于科学证据,包括权威指南、顶级专家经验和最新研究成果。

★AI辅助 无法替代医师

郭威注意到,尽管身边大多数医师对AI大模型等新技术持积极态度,但医师们也会讨论哪些科室的医师可能最先会被AI取代。他认为,涉及诊断影像的医师可能面临更大的被替代风险,例如,AI辅助的X光片和胸部CT阅片,能够发现许多肉眼难以察觉的小结节。随着AI技术不断进步,影像科医师的工作将更多转向辅助和审查。

「有些人担心AI医师的出现,会导致一些医师失业,这不会发生在儿科医师中。」倪鑫表示,AI医师与人类医师是相互支持的关系,AI更多是辅助医师,而非取代他们。

不少一线临床医师拥抱AI的同时,也保持着冷静。来自感染科、神经内科、外科等科室的多名临床医师透露,目前AI在临床中的作用主要是辅助,无法替代医师的决策。北京大学第一医院神经内科主任医师孙永安说,尽管AI在分析和集成现有数据方面表现出色,但它缺乏真正的创新能力,无法独立探索未知领域。而医学的进步往往来源于突破性的创新。

「无论技术多先进,AI始终难以替代医师的深度思考和即时应变。」武汉一家部署DeepSeek的三甲医院急诊科医师魏明(化名)表示,急诊科有时也需要对患者进行淋巴结活检。例如,在颈部进行淋巴结活检时,影像上显示的病变可能靠近血管。手术过程中,医师必须亲自观察并判断,精细分离淋巴结,同时防止出血。即使AI能标出大致病灶位置,如何避开关键结构、确保安全切除,仍须医师根据病人具体情况作出判断。医师仍然是最终的决策者。

郁金泰表示,医师不仅具备专业背景,还能基于临床经验综合判断病情,这正是AI无法完全取代医师的内核所在。

AI在医疗领域的发展,不会停下脚步。「100万个儿科医师,这个目标听起来宏大,但现在已经基本实现了。我们的大模型理论上可以诞生成千上万的AI儿科医师。」倪鑫谈道,河北当地有150多家基层医院,希望能成为AI儿科医师的首批试点。北京儿童医院和百川智能计划先在京津冀地区的医院进行试点,再将AI儿科医师推广到全国各地。

黄虹表示,DeepSeek只是众多大模型中的一种,而大模型本身并非固定不变。从医院角度看,未来不仅关注单一模型的应用,而且要思考如何集成多种大模型,以便为不同领域提供精准支持,未来的AI医疗可能是「千模融合」。

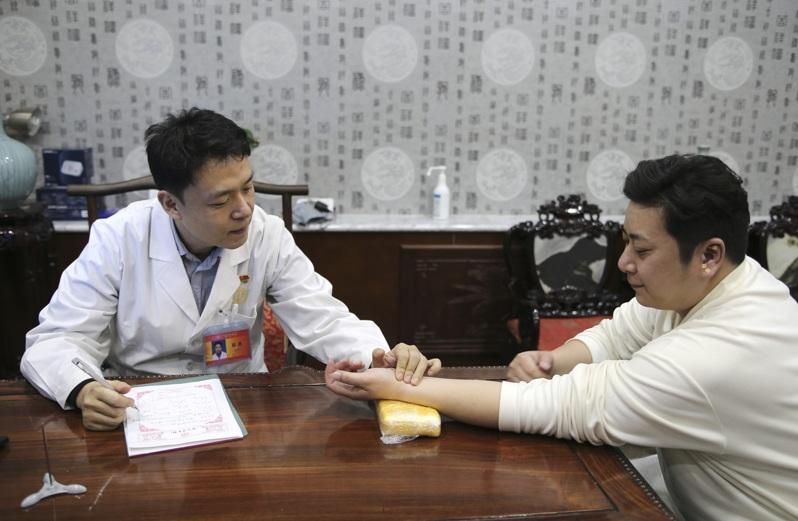

●AI中医无法望闻问切 自行抓药有风险

中国各大医院纷纷导入DeepSeek当AI医疗助理,一般民众也把DeepSeek当成医疗顾问,还有人照着DeepSeek的开的药方到中药房配药吃,但中医师强调,中医辩证需要「望闻问切」,聊天机械人只能作辅助,民众自行抓药有风险。

BBC报导,在小红书上,有关「DeepSeek看中医」的笔记就多达4万条。有人留言说,自己老婆咳了一个多月,中西医都没看好,但吃过四次DeepSeek推荐的药就好了,形容是「真正老百姓的福音」。

广州的妙妙妈妈今年34岁,她的女儿去年感染支原体肺炎,身体变得脆弱,严重时每个星期都发高烧,又患上过敏性鼻炎。妙妙妈妈连续15天让DeepSeek诊断女儿的症状,「稍微有一点着凉,或者大便有点拉稀,我都会问」,她再按照推荐的中药配给女儿吃。

妙妙妈妈详细记录女儿的变化:服药的第二天,手心热的女儿温度恢复正常,大便变得畅通;第三天,食欲增强;第七天,肤色亮起来了,「不像之前一脸黄气」。她看着女儿身体一点点好起来,感到很兴奋,「我觉得它很厉害、很对症」。

可是在评论区中有不少反对声音,有人批评她太轻率:「胆子上天了,AI离替代中医大夫还差十万八千里」;也有人说方子「治标不治本」。但妙妙妈妈说, 「我只看效果」。

事实上,用聊天机器人看病不是新鲜事。在ChatGPT问世之后,国外不少人向它寻求医疗建议,而无论病人或医师,给出的评价都相当正面。美国和德国都有研究显示,参与盲测的病人认为GhatGPT的回应更有同理心和更有用。

报导指出,来自湖南的袁莉有两个孩子,她也觉得AI分析「挺靠谱的」。在中国看西医,一般会做血常规等检验。但袁莉说,即使孩子的指针出现不正常,医师也不会详细解释。以前,她会去百度逐项搜索各项数据的意义,后来她把检验单发给DeepSeek,AI马上给她分析下诊断,还推荐用药。袁莉不得由衷赞叹:「DeepSeek真的很强。」

人们没有被医师解决的焦虑,在机器人的耐心下抚平。但是关键问题是,ChatGPT在西医应用成功,DeepSeek能否在中医上拷贝?

大语言模型(LLM)主要通过投喂大量数据来进化,而西医依赖统一的指针、数据集成来断症,要训练它,就像是一个「啃指导的过程」,但中医不是这样。北京中医药大学中医内科研究生、中国注册中医师花猫(化名)分析,中医各流派没有统一,「对于同样一个消息,大家理解维度不一样,思路也不一样。」换句话说,当AI要代入中医诊断,因为有很多数据参考,得出来的治疗方案未必一致。

澳门科技大学中医药学院前院长周华说,中医辩证讲求「望闻问切」,每个步骤都是辩证的重要参数,但DeepSeek目前只能「问」,靠病人给它提供的资讯(prompt)断症,倘若资讯有所缺失,效果也会天差地别。

一名香港注册中医师卓健(化名)表示,中药一向给人温和不伤身的印象,也正是因为这种错觉,人们轻视了中药的危险性。「大家经常觉得是无副作用、是天然的,所以大家会很容易去买一些自己煲来吃,很多时候都煲出事。」在香港,自2008年到2021年的13年间,怀疑服用中药或中成药中毒的个案就超过4900宗,更有许多人因为没有咨询中医师自行用药,导致「乌头碱」中毒。

卓健认为,人们用DeepSeek开药方的趋势,就像以前电视节目或报纸教煲「保健汤方」—开方者未必十分了解清楚大众体质,大众也不确定药方是否适合自己。他说,如今聊天机器人的出现,只是令过去的现象和风险更普遍。

不过据花猫观察,DeepSeek目前开的方子还算是保守安全,「你要是怕冷,它可能大概就用附子、桂枝、生姜,要是脾胃不好就白术、茯苓、人参。」花猫说,它一般都是在常见的名方上修改,药方没见用上毒药,剂量也算安全,就算喝多了,「最多也就是上上火」。

至于会否造成长远伤害的问题,花猫觉得人会有自控能力,「吃这个玩意不舒服,一般自己就会停(药)了。」但如果有人真的把它当作权威而吃错了,也只能怪自己:「怎么能相信一个机器呢?」